Como três séculos de inovação criaram o mundo digital que conhecemos hoje

Por que Entender a História da Computação Importa?

Existe uma frase que me marca profundamente: “existem umas coisas em ciência, que você pode não saber, sua vida vai ser normal. Mas, se você souber, você tem uma leitura mais crítica dos fatos que estão envolvidos no nosso dia-a-dia”.

Quando pegamos nosso smartphone pela manhã, abrimos o laptop para trabalhar ou assistimos nossa smart TV à noite, estamos interagindo com séculos de inovação humana. Compreender essa evolução não nos torna apenas usuários mais conscientes da tecnologia, mas cidadãos mais críticos, capazes de entender e questionar o papel crescente da computação em nossas vidas.

Esta é a história de como chegamos até aqui – uma jornada fascinante de mentes curiosas, necessidades práticas e descobertas que mudaram o mundo.

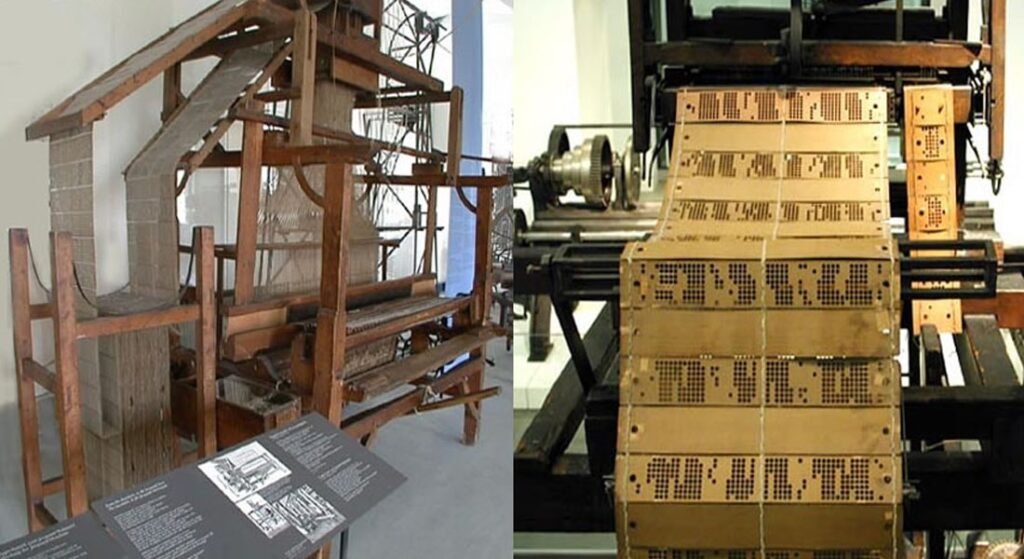

1804: Jacquard e os Primeiros Passos da Automação

Nossa história começa na França napoleônica, com uma invenção que transformaria para sempre a produção têxtil. A máquina de tear de Joseph Marie Jacquard, patenteada em 1804, introduziu um conceito revolucionário: a automação de processos complexos através de informações codificadas.

A genialidade de Jacquard estava nos cartões perfurados. Cada furo representava uma instrução específica para a máquina: quais fios levantar, quais abaixar, criando complexos desenhos em tapetes e tecidos. O mais impressionante era a reprodutibilidade – o mesmo conjunto de cartões podia ser usado infinitas vezes, produzindo sempre o mesmo padrão.

Pela primeira vez na história, um processo manual altamente especializado tornava-se completamente automatizado e padronizado. Os princípios estabelecidos por Jacquard – codificação de instruções, automação, reprodutibilidade e programabilidade – ecoariam por séculos na evolução tecnológica.

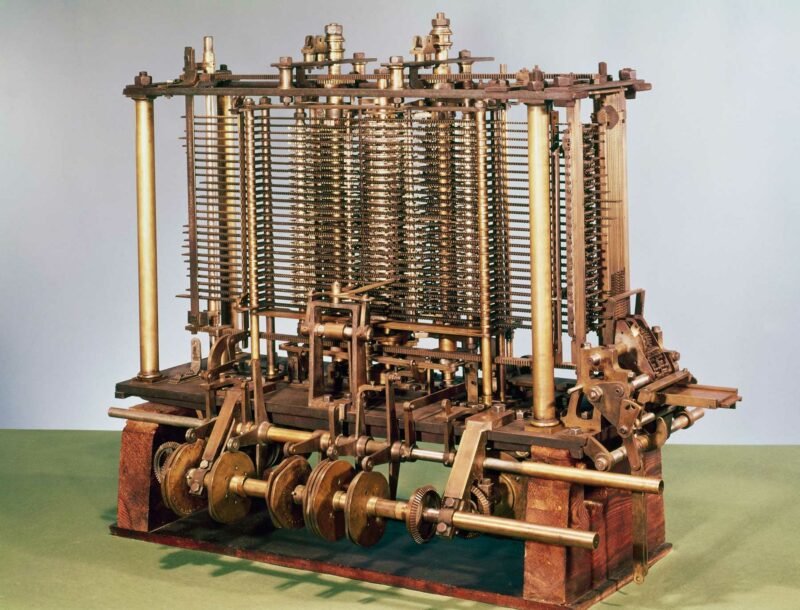

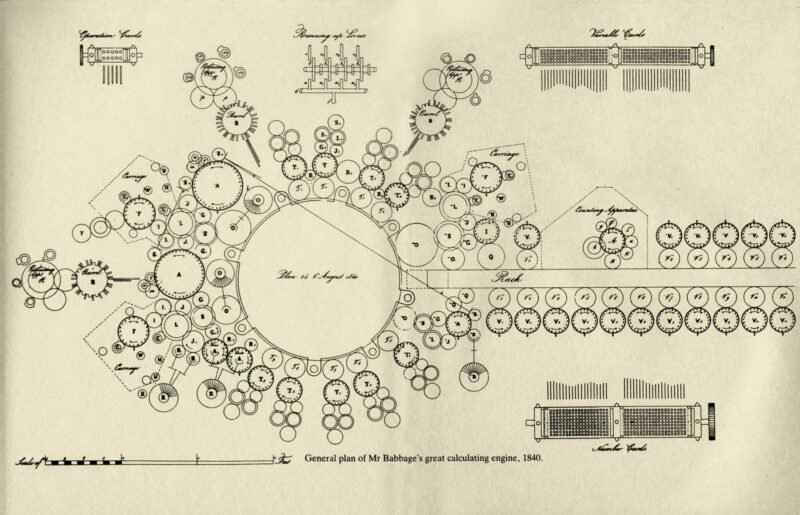

1830s: Babbage e a Visão da Computação Universal

Do outro lado do Canal da Mancha, o matemático britânico Charles Babbage enfrentava um problema que afligia toda a comunidade científica: os erros constantes nas tabelas logarítmicas.

No século XIX, essas tabelas eram ferramentas essenciais para ciências, finanças, engenharia e planejamento governamental. O problema era que, calculadas manualmente, continham inúmeros erros humanos, comprometendo resultados cruciais em diversas áreas.

Obcecado por resolver essa questão, Babbage dedicou uma década ao Motor de Diferenças, uma máquina capaz de resolver equações polinomiais através do método das diferenças finitas. Mas sua visão ia muito além.

O Motor de Diferenças foi a base para sua idealização mais ambiciosa: a Máquina Analítica, um dispositivo de uso geral projetado para realizar qualquer tipo de cálculo. Esta máquina já contemplava os elementos fundamentais dos computadores modernos:

- Memória – espaço para armazenar informações processadas

- Processamento – unidade dedicada aos cálculos

- Lógica condicional – capacidade de tomar decisões

- Programabilidade – possibilidade de executar diferentes sequências de operações

Embora nunca tenha sido completamente construída devido às limitações tecnológicas da época, a Máquina Analítica estabeleceu os fundamentos conceituais da computação moderna.

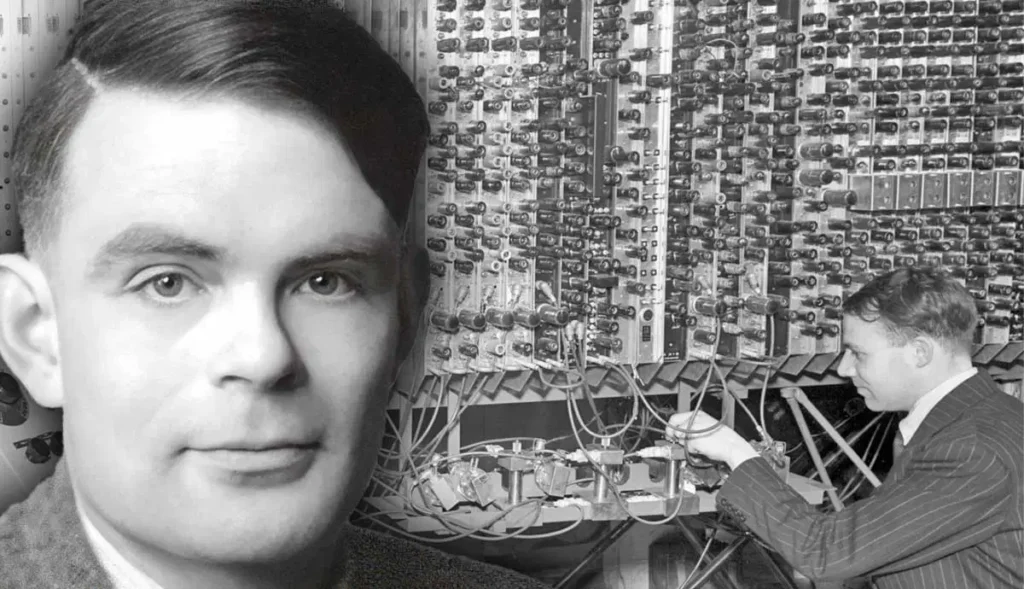

1936: Turing e os Fundamentos Teóricos

No século XX, a questão da computação ganharia uma dimensão ainda mais profunda com o trabalho do prodígio britânico Alan Turing.

Turing não estava simplesmente tentando construir uma calculadora. Ele buscava responder a uma das questões mais fundamentais da matemática, conhecida como Entscheidungsproblem (problema da decisão): existe algum procedimento sistemático que possa determinar se uma afirmação matemática é verdadeira ou falsa?

Sua resposta veio na forma da Máquina de Turing, elegantemente simples em conceito, mas infinitamente poderosa em potencial. A máquina funcionava com uma fita infinita, um cabeçote de leitura/escrita e um conjunto básico de operações: ler, escrever, mover-se e mudar estados internos.

Com esse conjunto aparentemente limitado de operações, a Máquina de Turing podia executar qualquer algoritmo concebível, incluindo sequências de instruções, estruturas condicionais, loops e recursão – o DNA da computação moderna.

A Década Crucial: Os Anos 1930

A década de 1930 marcou um momento extraordinário de convergência científica. Movidos por frustrações similares com as limitações das calculadoras mecânicas da época – lentas, propensas a erros e inadequadas para cálculos complexos – pesquisadores independentes ao redor do mundo começaram a sonhar com máquinas computacionais revolucionárias.

Na Alemanha, Konrad Zuse concebia em 1936 um computador mecânico programável por marcações em fita. No mesmo ano, Alan Turing publicava seu paper sobre números computáveis, introduzindo à comunidade acadêmica o conceito de máquina universal.

Em Harvard, o físico Howard Aiken, inspirado nos projetos de Babbage, determinava-se a construir uma máquina que resolvesse as equações diferenciais não lineares que encontrava em sua dissertação. Na Universidade Estadual de Iowa, John Atanasoff empenhava-se em construir uma máquina para resolver sistemas de equações algébricas lineares.

E na lendária Bell Labs, George Stibitz experimentava com uma abordagem revolucionária: construir uma calculadora usando relays elétricos, substituindo os processos mecânicos das calculadoras de mesa da época e dando origem ao BTL1 – um marco na transição da computação mecânica para a eletrônica.

Esta convergência ilustra um princípio fundamental: o conhecimento duradouro constrói-se sobre bases anteriores. Cada inovação – de Jacquard a Turing, de Babbage aos pioneiros dos anos 1930 – representou não uma criação isolada, mas a síntese criativa de ideias precedentes combinadas com necessidades contemporâneas.

1946: ENIAC e a Era dos Gigantes Eletrônicos

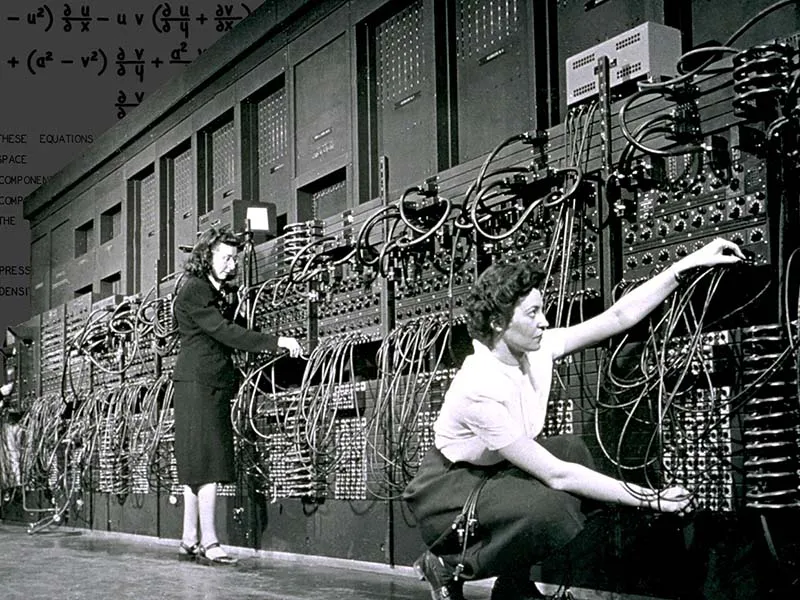

A Segunda Guerra Mundial acelerou dramaticamente estes desenvolvimentos experimentais. Em 1946 entrou em operação o ENIAC (Electronic Numerical Integrator and Computer), o primeiro dispositivo computacional eletrônico e digital de grande escala.

Idealizado desde 1937 pelos cientistas norte-americanos John Eckert e John Mauchly, o projeto foi pensado para ajudar o exército americano nos cálculos balísticos durante a guerra. Embora tenha ficado pronto após o conflito, o ENIAC representou um salto gigantesco da teoria à realidade prática.

O ENIAC funcionava sendo programado fisicamente por mulheres da Universidade da Pensilvânia – matemáticas especializadas que conheciam profundamente o funcionamento da máquina. Este detalhe revela um aspecto fascinante: antes do ENIAC, existia uma equipe de 200 mulheres cuja função era calcular manualmente as equações necessárias para os cálculos balísticos. Estas profissionais eram conhecidas como “computadores” – origem humana do termo que hoje associamos às máquinas.

Após o advento do ENIAC, apenas 6 dessas programadoras eram necessárias para operar o gigante de 167 metros quadrados. A máquina foi extremamente importante no desenvolvimento da Bomba H e, após 10 anos de uso, foi aposentada em 1955 por tornar-se obsoleta.

O Nascimento da Computação Comercial

O primeiro computador comercial foi o UNIVAC, sucessor do ENIAC, utilizado no censo americano pós-guerra. O governo precisava de uma forma mais ágil de processar a crescente população americana, e a solução veio da máquina construída na Remington-Rand pelos mesmos criadores do ENIAC. A empresa vendeu 46 unidades custando $1.000.000 cada – um investimento astronômico que apenas grandes organizações podiam fazer.

Uma das grandes inovações que acompanhou o UNIVAC foi o embrião das linguagens de programação modernas. A matemática Grace Hopper completou em 1952 o projeto A-0, um compilador que transformava notações matemáticas em instruções de máquina – um conceito revolucionário que facilitaria drasticamente a programação.

A Era IBM: Dominância e Padronização

Do início dos anos 1950 ao final dos anos 1970, a presença da gigante americana IBM foi dominante na indústria dos grandes computadores com suas séries 700 e, posteriormente, os System/360.

A série 700 era usada principalmente no mercado científico, mas carregava um grande inconveniente: cada vez que a tecnologia evoluía e outro modelo era lançado, programas e periféricos do modelo anterior se tornavam incompatíveis, gerando custos enormes para os clientes.

A série System/360 veio para solucionar isso, desenvolvendo o conceito revolucionário de família de computadores compatíveis. Mesmo em máquinas diferentes, aplicações e periféricos podiam ser reaproveitados, economizando esforços e dinheiro das empresas. Este conceito de compatibilidade ascendente transformou a indústria e ainda influencia o design de sistemas modernos.

A Revolução dos Microcomputadores

Por décadas, os computadores permaneceram como gigantes eletrônicos confinados em salas refrigeradas, operados por especialistas de jaleco branco, processando dados para governos e grandes corporações. Mas uma revolução silenciosa estava por vir – uma que levaria o poder computacional das catedrais tecnológicas às mesas de escritório, e eventualmente, aos lares de milhões de pessoas.

O Altair 8800: Marco Zero de uma Nova Indústria

O Altair 8800, lançado em 1975 pela MITS por apenas $439 em kit, representou muito mais que um computador pessoal pioneiro. Foi o marco zero de uma nova indústria multibilionária que nasceria nas próximas décadas. Pela primeira vez, a computação saía dos laboratórios corporativos e entrava no domínio de entusiastas, hobbyistas e empreendedores visionários – muitos deles trabalhando em garagens no Vale do Silício.

O Altair não tinha teclado, monitor ou sistema operacional – apenas luzes piscantes e chaves. Mas estabeleceu algo fundamental: a possibilidade de pessoas comuns possuírem e controlarem computadores.

A Grande Corrida Tripartite (1975-1990)

O sucesso do Altair desencadeou uma das competições mais intensas da história empresarial, envolvendo três gigantes que definiriam o futuro da computação pessoal.

Apple: A Revolução da Usabilidade

Steve Jobs e Steve Wozniak, inspirados pelo Altair, fundaram a Apple em 1976 com uma visão radical: computadores não deveriam ser apenas para engenheiros, mas para pessoas comuns. O Apple II (1977) provou que existia um mercado massivo para computadores pessoais amigáveis, gerando bilhões em receita e estabelecendo a Apple como pioneira em design e experiência do usuário.

Microsoft: O Império do Software

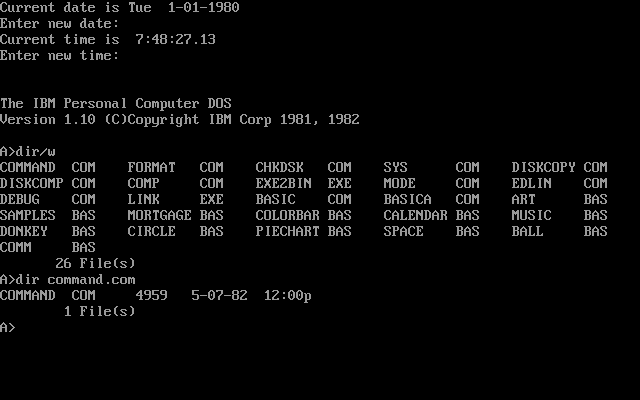

Enquanto isso, Bill Gates e Paul Allen perceberam que o verdadeiro valor não estava no hardware, mas no software. Fundada em 1975, a Microsoft inicialmente fornecia linguagens de programação, mas sua grande oportunidade veio quando a IBM precisou de um sistema operacional para seu PC. O MS-DOS, e posteriormente o Windows, transformariam a Microsoft na maior empresa de software do mundo.

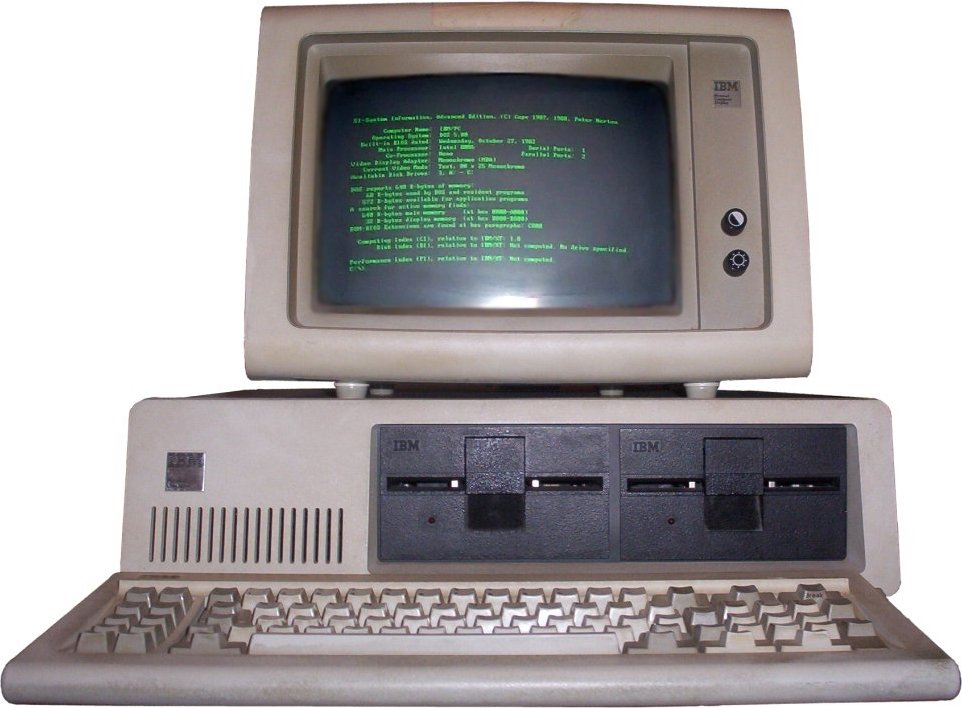

IBM: O Gigante Acordado

A IBM, inicialmente cética sobre computadores pessoais, foi forçada a reagir quando viu o crescimento explosivo do mercado. A criação da divisão de PCs em 1980 e o lançamento do IBM PC em 1981 legitimaram definitivamente o mercado de computadores pessoais.

A Decisão que Mudou Tudo: Arquitetura Aberta

Em 1981, a IBM tomou uma decisão que mudaria para sempre a indústria de computadores pessoais. Ao contrário de sua tradição centenária de sistemas proprietários e fechados, a divisão de computadores pessoais da IBM optou por uma arquitetura completamente aberta para o IBM PC.

Esta escolha, motivada pela necessidade de entrar rapidamente no mercado dominado pela Apple, teve consequências que nem a própria IBM previu. Ao publicar as especificações técnicas, usar componentes padronizados (processador Intel 8088, sistema operacional MS-DOS licenciado) e criar slots de expansão abertos, a IBM não apenas criou um produto – criou um ecossistema.

As Consequências Não Intencionais

A arquitetura aberta levou ao nascimento dos “IBM compatíveis”, com a Compaq sendo a primeira empresa a criar um clone bem-sucedido. O que se seguiu foi uma commoditização do hardware que reduziu drasticamente os preços e acelerou a inovação.

Ironicamente, os verdadeiros vencedores desta estratégia foram a Microsoft (que licenciou o MS-DOS para todos os fabricantes) e a Intel (que forneceu processadores para todo o ecossistema). A IBM acabou perdendo o controle do mercado que havia criado.

O Momento Xerox: A Interface Gráfica

Em 1979, Steve Jobs visitou o laboratório PARC da Xerox e testemunhou algo revolucionário: computadores controlados por mouse, com janelas, ícones e menus gráficos ao invés de comandos de texto. Jobs imediatamente reconheceu o potencial transformador desta interface gráfica.

A Apple incorporou essas ideias no Lisa (1983) e depois no Macintosh (1984), criando o primeiro computador pessoal comercialmente bem-sucedido com interface gráfica completa. O famoso comercial do Super Bowl declarou: “Em 24 de janeiro, a Apple Computer introduzirá o Macintosh. E você verá por que 1984 não será como 1984.”

Microsoft, percebendo a ameaça, correu para desenvolver o Windows, lançado em 1985. O que se seguiu foi uma das rivalidades mais intensas da história da tecnologia: Apple apostando em hardware integrado e experiência premium, Microsoft focando em software licenciável para múltiplos fabricantes.

A Corrida pelos Nichos Estratégicos

Esta competição estabeleceu os paradigmas fundamentais que ainda dominam a indústria hoje:

Hardware: Integração vs. Padronização

- Apple: Integração vertical, controle total da experiência do usuário

- IBM/Compatíveis: Arquitetura aberta, economia de escala, diversidade de fabricantes

Software: Exclusividade vs. Ubiquidade

- Microsoft: Estratégia de licenciamento, presença em múltiplas plataformas

- Apple: Software exclusivo para hardware próprio, experiência integrada

Sistemas Operacionais: Volume vs. Qualidade

- MS-DOS/Windows: Dominância no mercado corporativo e doméstico

- Mac OS: Liderança em design gráfico, educação e criatividade

O Legado: Como Chegamos Até Hoje

Esta corrida pelos anos 1980 e 1990 não apenas criou algumas das maiores empresas da história, mas estabeleceu debates fundamentais que continuam relevantes:

- Padronização vs. Integração: O eterno debate entre sistemas abertos e fechados

- Hardware vs. Software: Onde reside o verdadeiro valor na cadeia tecnológica

- Interface: A transição definitiva de comandos de texto para interfaces gráficas intuitivas

É fascinante perceber como elementos que consideramos óbvios hoje – ícones na tela, janelas que se sobrepõem, o conceito de “arquivo” e “pasta” – foram inovações revolucionárias que precisaram ser inventadas, testadas e aperfeiçoadas.

Reflexão: A Construção Cumulativa do Conhecimento

A arquitetura aberta do IBM PC exemplifica perfeitamente como o conhecimento duradouro se constrói: a IBM não reinventou tudo do zero, mas estudou o que já existia (Altair, Apple II), exercitou os princípios aprendidos e propôs um novo uso – a padronização aberta – baseado em sua experiência corporativa.

É assim que se constrói conhecimento duradouro e de valor: estudando o que já foi feito, exercitando o que se aprende e propondo novos usos a partir de nossas vivências pessoais.

Cada inovação que exploramos – dos cartões perfurados de Jacquard aos algoritmos de Turing, da Máquina Analítica de Babbage aos microprocessadores da Intel – representa uma camada na construção coletiva do conhecimento humano.

Conclusão: O Mundo Digital que Habitamos

Hoje, quando desbloqueamos nosso smartphone, fazemos uma videochamada ou pedimos para a Alexa tocar nossa música favorita, estamos utilizando o resultado de séculos de inovação cumulativa. Cada gesto simples do nosso cotidiano digital carrega em si a herança de mentes curiosas que se recusaram a aceitar as limitações de sua época.

De computadores de mesa a notebooks, relógios inteligentes e smart TVs, videogames e celulares – tudo isso é baseado nos modelos e princípios estabelecidos por Turing, implementado em arquiteturas conceituais idealizadas por Babbage, executando em sistemas que evoluíram da visão de compatibilidade da IBM, com interfaces gráficas nascidas na Xerox e popularizadas pela Apple e Microsoft.

A próxima vez que você interagir com qualquer dispositivo digital, lembre-se: você está segurando nas mãos não apenas tecnologia, mas séculos de curiosidade humana, perseverança científica e inovação colaborativa.

E esta história continua sendo escrita. Cada aplicativo que desenvolvemos, cada problema que automatizamos, cada interface que simplificamos é mais um capítulo nesta fascinante jornada da computação.

A pergunta que fica é: qual será sua contribuição para os próximos capítulos desta história?

Este artigo faz parte do curso “Computação Essencial: Da História à Prática”, uma jornada completa para compreender os fundamentos da computação moderna e dar os primeiros passos rumo a uma carreira em tecnologia.

Curiosidade histórica: O termo “biblioteca” em programação vem de “tape library” (bibliotecas de fitas) – as fitas de papel perfurado que continham as instruções dos primeiros programas. Mais uma conexão fascinante entre o passado e presente da computação!

Referências

Vídeos do YouTube

MÁQUINAS de Turing – Como a Ciência da Computação Foi Criada por Acidente. YouTube, 2024. Disponível em: https://www.youtube.com/watch?v=PLVCscCY4xI. Acesso em: 5 ago. 2025.

VÍDEO sobre História da Computação. YouTube, 2024. Disponível em: https://www.youtube.com/watch?v=j2fURxbdIZs. Acesso em: 5 ago. 2025.

HISTÓRIA da Computação – Parte 1. YouTube, 2024. Disponível em: https://www.youtube.com/watch?v=AIBr-kPgYuU&list=PLVv7pqeHswO-32gVlxT1EhaBUKThmNvb7. Acesso em: 5 ago. 2025.

HISTÓRIA da Computação – Parte 2. YouTube, 2024. Disponível em: https://www.youtube.com/watch?v=MSSjaGbM7j0&list=PLVv7pqeHswO-32gVlxT1EhaBUKThmNvb7&index=2. Acesso em: 5 ago. 2025.

DOCUMENTÁRIO sobre Computação. YouTube, 2024. Disponível em: https://www.youtube.com/watch?v=RPQD7-AOjMI&t=61s. Acesso em: 5 ago. 2025.

EVOLUÇÃO dos Computadores. YouTube, 2024. Disponível em: https://www.youtube.com/watch?v=9CvWBiWGw2M. Acesso em: 5 ago. 2025.

Artigos e Fontes Online

IBM 701. In: Wikipedia, a enciclopédia livre. Wikimedia Foundation, 2024. Disponível em: https://en.wikipedia.org/wiki/IBM_701#:~:text=The%20IBM%20701%20Electronic%20Data,public%20on%20May%2021%2C%201952. Acesso em: 5 ago. 2025.

IBM System/360. In: Wikipedia, a enciclopédia livre. Wikimedia Foundation, 2024. Disponível em: https://en.wikipedia.org/wiki/IBM_System/360. Acesso em: 5 ago. 2025.

COMPUTER History Museum. Timeline of Computer History. Computer History Museum, 2024. Disponível em: https://www.computerhistory.org/timeline/. Acesso em: 5 ago. 2025.